全球下載前列!天娛數科開源3D鉸接數據集,破解機器人“行動智能”難題

2025-10-31

在全球競逐的具身智能產業賽道中,高質量3D數據已成為各國突破技術瓶頸的核心戰略資源。過去十年,ModelNet、ShapeNet等歐美主導的經典數據集奠定了物體幾何建模基礎,Objaverse-XL將3D資產規模拓展至百萬級,但這些數據多停留在靜態幾何層面,難以捕捉真實世界的物理交互特性。即便近年PartNet-Mobility、SAPIEN等數據集嘗試引入可動性概念,但受限于數據規模、動作一致性與物理精度,仍無法支撐機器人復雜操作學習需求。

要讓機器人真正具備抓取、推拉、插拔等具身交互能力,AI必須建立在高質量、結構化、具有物理約束的鉸接物體數據(ArticulatedObjects)之上。天娛數科打造的BehavisionPro空間智能MaaS平臺已累計超150萬條3D數據和65萬條多模態數據,以及豐富的3D鉸接數據。3D鉸接數據不僅可以幫助機器人更精準地認知物體結構和動態關系,也為后續的智能推理、動作生成、場景操作提供了堅實的基礎。

Behavision構建的3D鉸接數據集自發布以來,在全球3D鉸接數據集中持續位列HuggingFace下載榜前列,被廣泛應用于VLA模型及強化/模仿學習(RL/IL)任務中,充分體現了在數據一致性、物理精度與行為可解釋性方面的卓越優勢,成為具身智能領域的重要基礎資源。

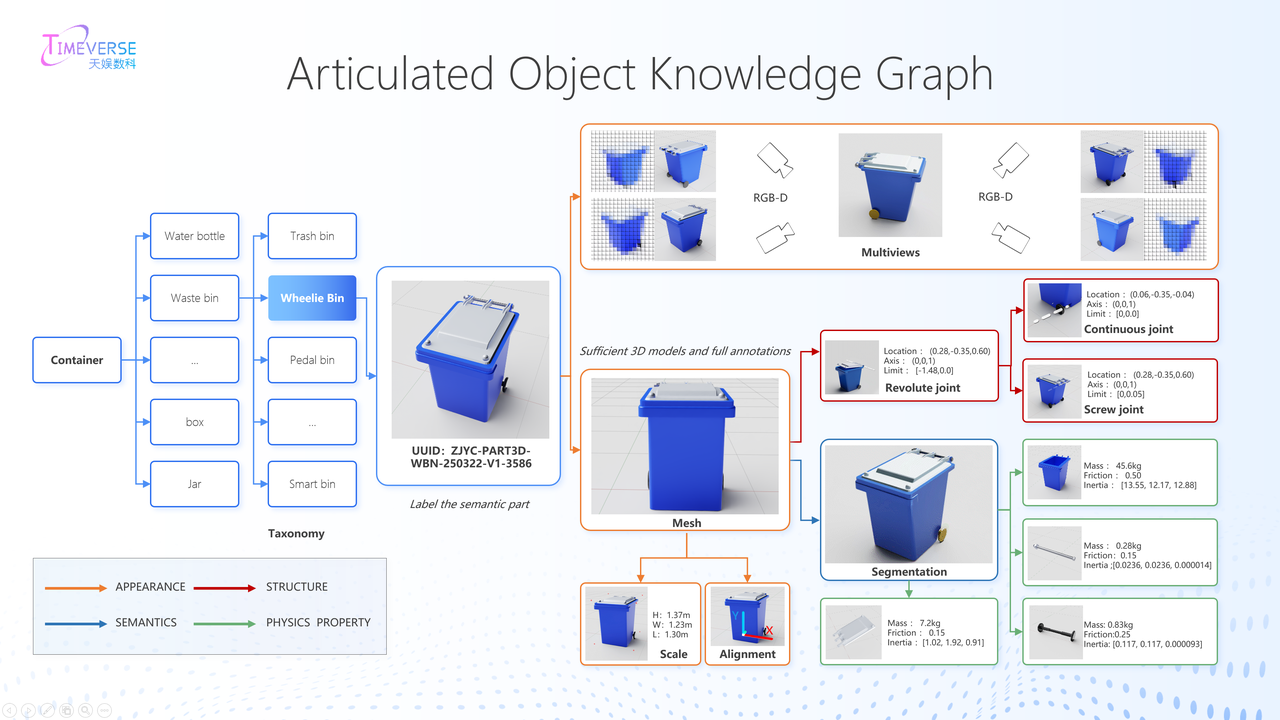

與傳統僅描述物體“是什么”的3D數據不同,Behavision 3D鉸接數據集進一步定義了“如何操作對象”的行為邏輯,構建起貫通感知到行為的系統化表達框架。

其核心特征涵蓋四個層面:在外觀層提供RGB、深度、法線等多模態渲染,支撐視覺學習;在結構層覆蓋旋轉(revolute)、滑動(prismatic)等多種關節類型,精準描述可動邏輯;在語義層標注可交互部件與動作方向,引導策略生成;在物理層定義質量、慣量、摩擦等動力學參數,確保仿真符合真實物理規律。依托這一高維結構化的數據體系,Behavision 3D鉸接數據集成為連接“視覺識別”與“行為生成”的關鍵橋梁,支撐Real2Sim2Real閉環學習——以真實數據校準仿真、以仿真策略反哺現實,顯著縮小Sim2RealGap,推動機器人實現從感知理解到任務執行的智能躍遷。

具身智能的躍遷,本質是“數據能力”的躍遷。從靜態幾何到動態交互,從單一感知到全鏈路行為,3D數據正從“基礎資源”升級為“核心競爭力”。Behavision 3D鉸接數據集通過結構化設計與物理真實性突破,為當前鉸接數據稀缺的瓶頸提供了可行方案。

未來,天娛數科將持續加大對行為導向的3D數據資產投入力度,不斷優化與拓展數據集內容,構建高標準、可擴展的仿真數據體系,為通用具身智能體的研發提供系統化、結構化的物理世界數據支撐,并以開放共建的姿態攜手全球科研機構與開發者,推動行業數據基礎設施的升級與互通,促進復雜機器人行為的學習與泛化,加速具身智能時代的全面到來。